Embora os computadores modernos operem com tecnologias avançadas como Unicode, UTF-8 e comunicação binária complexa, a Tabela ASCII (American Standard Code for Information Interchange) permanece uma das bases fundamentais da computação, especialmente no universo dos microcontroladores e sistemas embarcados. Neste artigo, vamos revisitar a história da tabela ASCII, explorar suas versões de 128 e 256 bytes, analisar sua importância prática, e entender algumas de suas curiosidades mais instigantes, como a razão dos números, letras maiúsculas e minúsculas estarem estrategicamente posicionados em seus respectivos intervalos binários.

A História da Tabela ASCII

A história da Tabela ASCII começa no início da década de 1960, quando a necessidade de uma padronização para troca de informações entre diferentes sistemas se tornou evidente. Antes disso, cada fabricante de computadores utilizava seu próprio conjunto de códigos para representar caracteres, o que tornava extremamente difícil a interoperabilidade.

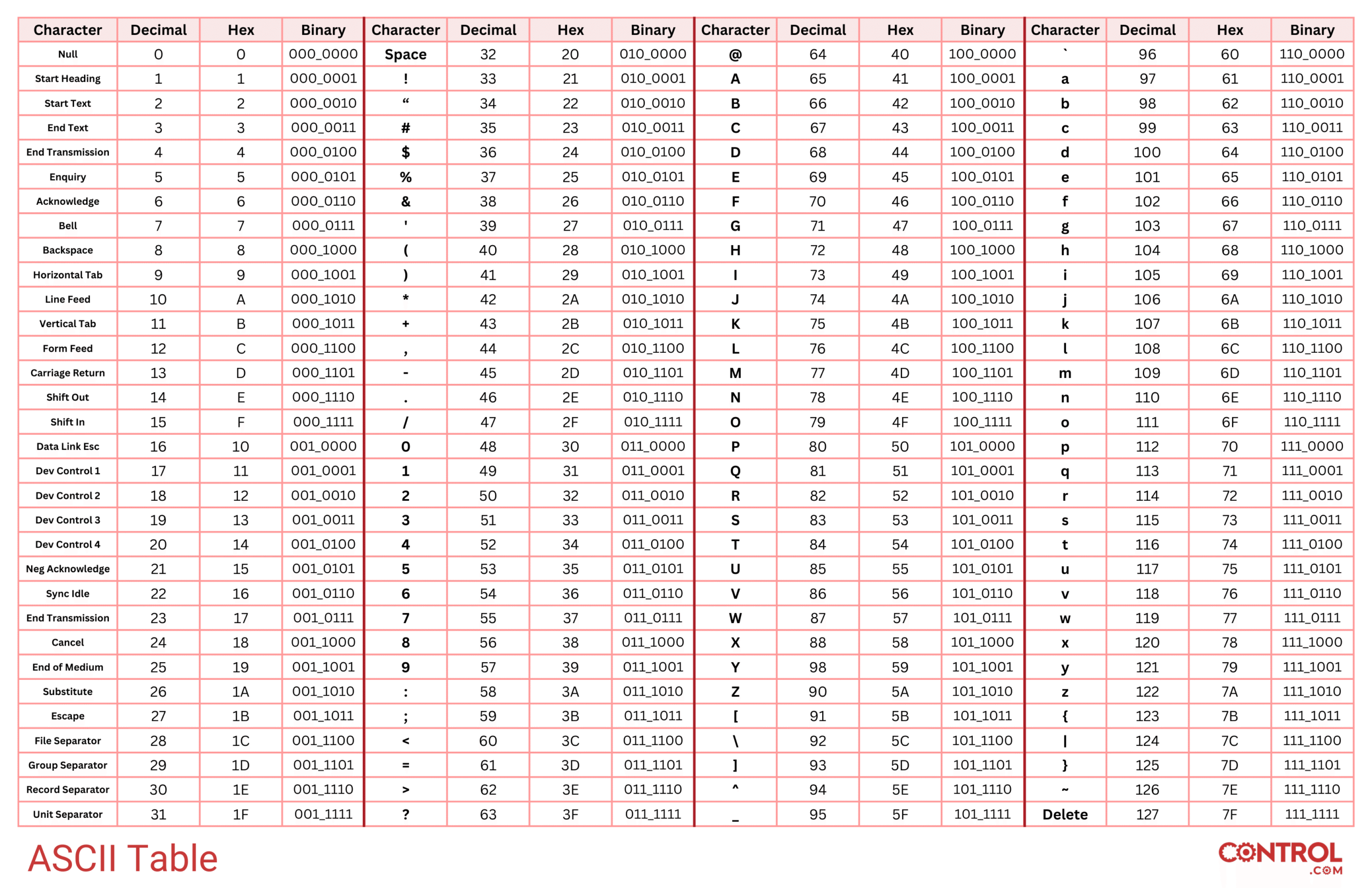

Foi então que o American National Standards Institute (ANSI) propôs a criação de uma tabela comum: em 1963, o Comitê ASA X3.2 (posteriormente ANSI X3) publicou a primeira versão do ASCII, padronizando 128 símbolos codificados em 7 bits. O objetivo era representar letras, números, sinais de pontuação e caracteres de controle (como “Enter” e “Backspace”) de maneira universal.

Posteriormente, com a popularização de novos dispositivos e a necessidade de representar símbolos gráficos, caracteres especiais e idiomas além do inglês, surgiram extensões de 8 bits, ampliando a tabela para 256 posições — essa versão expandida ficou conhecida como Extended ASCII.

A versão de 128 bytes e a expansão para 256 bytes

A versão original da tabela ASCII, de 128 bytes (ou 7 bits), contém:

- 33 caracteres de controle (códigos 0–31 e 127),

- 95 caracteres imprimíveis, incluindo letras, números, pontuações e símbolos.

Essa versão foi suficiente para a comunicação básica, mas com o tempo, surgiram necessidades específicas — como a representação de caracteres acentuados usados em outros idiomas. Isso levou a extensões proprietárias e, depois, à padronização de versões de 8 bits, conhecidas coletivamente como tabelas estendidas. Essas extensões mantêm os 128 primeiros caracteres intactos e utilizam os códigos de 128 a 255 para símbolos adicionais.

A Importância do ASCII no Texto de Microcontroladores

Nos microcontroladores — especialmente nos dispositivos de 8, 16 e 32 bits — o ASCII continua sendo essencial. Muitos sistemas embarcados possuem recursos limitados de memória e processamento, e a simplicidade do ASCII é perfeita para:

- Transmissão de dados via UART (Universal Asynchronous Receiver-Transmitter),

- Comunicação entre sensores e dispositivos por protocolos simples como I2C ou SPI,

- Armazenamento de logs e mensagens de depuração,

- Interpretação de comandos recebidos de terminais seriais.

Por usar uma codificação simples e leve, o ASCII ajuda a reduzir o overhead, sendo ideal para sistemas que precisam de alta confiabilidade e baixo consumo de energia.

Curiosidade: Por que os números começam em 110000, as letras maiúsculas em 1000001 e as minúsculas em 1100001?

Esses valores binários correspondem, respectivamente, aos números:

110000= 48 (Decimal), que é o caractere'0',1000001= 65 (Decimal), que é a letra'A',1100001= 97 (Decimal), que é a letra'a'.

O motivo dessa estratégia é profundamente engenhoso:

O projeto da tabela ASCII foi pensado para facilitar a conversão e a comparação entre diferentes tipos de dados apenas com operações lógicas simples, diretamente em hardware.

Para os números:

- Os dígitos

'0'a'9'são sequenciais de 48 a 57. - Isso significa que para converter um caractere numérico em valor inteiro, basta subtrair 48 do valor ASCII.

Para as letras:

- As letras maiúsculas

'A'a'Z'ocupam os códigos de 65 a 90. - As letras minúsculas

'a'a'z'vão de 97 a 122. - A diferença entre

'A'e'a'é sempre 32 (em binário: diferença de um bit no sexto bit), permitindo transformar maiúscula em minúscula (ou vice-versa) simplesmente usando operações de máscara de bits (AND,OR,XOR).

Essa estrutura binária otimizada permitia que os primeiros computadores realizassem conversões de letras e números sem cálculos complexos, economizando ciclos de processamento em uma época onde cada ciclo contava.

Sobre o Autor

Carlos Delfino

administrator

Um Eterno Aprendiz.

Professor de Introdução a Programação, programação com JavaScript, TypeScript, C/C++ e Python

Professor de Eletrônica Básica

Professor de programação de Microcontroladores.

Embarcatecher